Fooocusを作った研究者 Lvmin Zhang に迫る #Fooocus

・Lvmin Zhangさんは中国出身の若き研究者で、スタンフォード大学で博士課程に在籍。

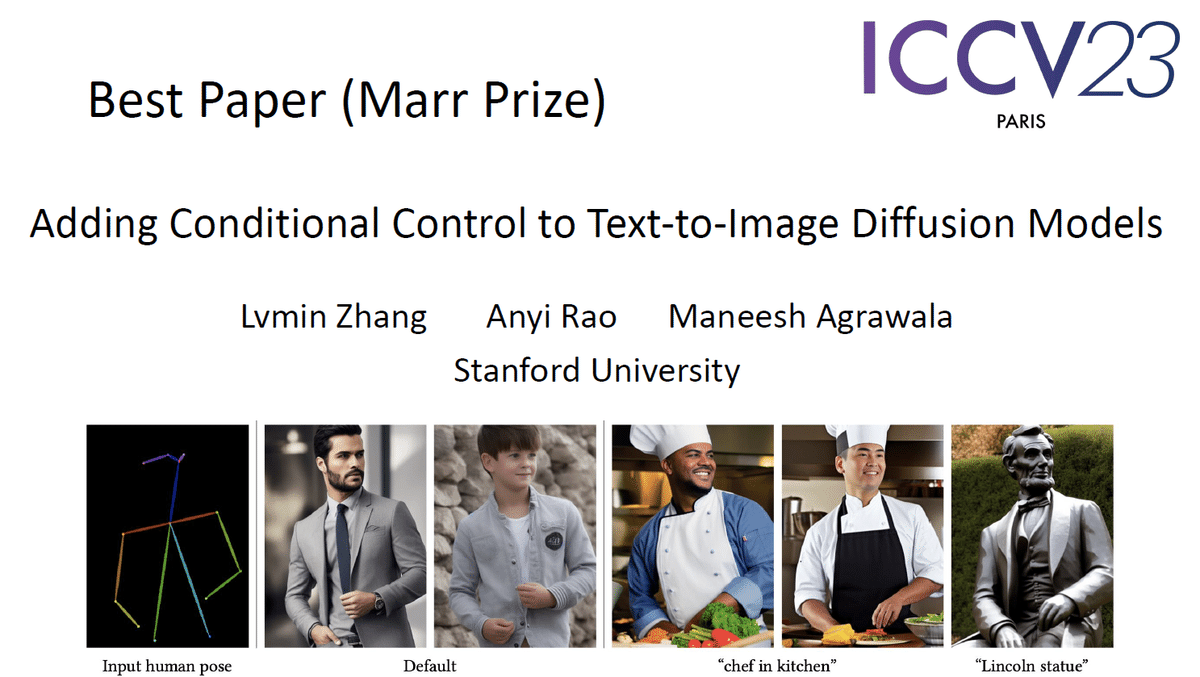

・彼は「Fooocus」や「Style2Paint」、さらに「ControlNet」の作者であり、ControlNetがICCV2023で最優秀論文賞を獲得。

・Lvminさんはコンピュータビジョンの分野で注目を集め、趣味はゲーム開発も含む多岐にわたる才能を持つ研究者です。

これまで数回に渡ってお手軽に高画質な画像が生成できるツール「Fooocus By lllyasvil」をフォーカスしてきました。

今回はこの「Fooocus」の作者はどんな人物なのか、リサーチしてみました。

Fooocusをつくた人はどんな人物なのか

「Fooocus」の開発者「 Lvmin Zhang さん」(GitHubアカウント: lllyasviel)は「Style2Paint」という色を塗るAIも古くから取り組まれている、中国出身の若き研究者です。現在はアメリカのスタンフォード大学の博士課程の学生さんのようです。

https://lllyasviel.github.io/Style2PaintsResearch/

実は Lvminさんは「Fooocus」や「Style2Paint」だけではなく「ControlNet」の作者でもあります。先日2023年10月2~6日にパリで開催されたコンピュータビジョンの国際会議「ICCV2023」において、ControlNetの論文が最優秀論文賞ベストペーパー(Marr Prize)の1つに選出されました。

25,221人以上の著者のトップということなので、これはかなりすごい。

International Conference on Computer Vision 「ICCV2023」

公式資料のダウンロードはこちら

https://iccv2023.thecvf.com/iccv2023.opening.slides-38--MTI.php

コンピュータビジョンの世界では中国がずば抜けて強い状況ですね。

こちらに日本の産業技術総合研究所(AIST)の上級主任研究員、片岡裕雄先生による「ICCV2023レポート」があるので、AIやコンピュータビジョンの学会や国際会議に興味のある方はこちらの資料もオススメです。

https://hirokatsukataoka.net/temp/presen/231006ICCV%202023%20Report%20(Release%20Ver.).pdf

受賞スライドはこちら。

Lvminさんの自己紹介サイトを訪ねてみました。

X(Twitter) https://twitter.com/lvminzhang

Lvmin Zhang は2022年からスタンフォード大学のManeesh Agrawala教授が指導するコンピューターサイエンスの博士課程に在籍している。それ以前は、2021年から香港中文大学のTien-Tsin Wong教授の研究室で助手を務めていた。Edgar Simo-Serra教授とも多くの興味深いプロジェクトで共同研究を行った。2021年に蘇州大学で工学学士号を取得し、Yi Ji教授とChunping Liu教授の指導を受けた。

Lvminの研究分野は、コンピュテーショナル・アートとデザイン、インタラクティブ・コンテンツ制作、コンピュータ・グラフィックス、画像・映像処理、ANIMEなど!これらをこよなく愛し、Style2Paints Researchという特別研究グループを組織している。また、Style2Paintsというアニメの描画ソフトも開発した。

LvminのGitHubと研究ページ

ちなみに趣味はゲーム開発だそうです

LvminはYGOPro2というUnityカードゲームの作者である。GoogleやYouTubeでこのゲームを検索すると、人気があることが分かるだろう。このゲームは多くの言語に翻訳され、世界中にファンがいる。

「Style2Paint」の研究ページを振り返ると2017年には現在のStable Diffusionの内部でも使われているU-netとGANを使ったアニメ風スケッチの画風転移学習の研究が発表されています。

Style Transfer for Anime Sketches with Enhanced Residual U-net and Auxiliary Classifier GAN, in Asian Conference on Pattern Recognition (ACPR) 2017.

Spotlight (5%) - The most cited paper of ACPR 2017 -

Lvmin Zhang, Yi Ji, and Xin Lin

早稲田大学のシモセラ エドガー先生とも共同研究があり、遊び心と日本のイラストレーション文化をよく研究されている人物であるということは覚えておくと良いと思います。

次回は「Fooocus」の最新機能について紹介したいと思います!

応援してくださる皆様へ!💖 いただいたサポートは、より良いコンテンツ制作、ライターさんの謝礼に役立てさせていただきます!